Anda pasti sudah mendengar tentang Hadoop, tetapi apa itu sebenarnya? Hadoop adalah framework sumber terbuka yang dirancang untuk memproses data dalam jumlah besar secara efisien. Dengan kemampuan untuk mengelola data terstruktur maupun tidak terstruktur, Hadoop menjadi solusi andalan banyak perusahaan besar.

Namun, tahukah Anda bahwa ada lebih dari sekadar pemrosesan data di dalamnya? Dalam artikel ini, kami akan membahas berbagai jenis Hadoop, manfaat utamanya, dan beberapa contoh penggunaannya yang sangat relevan di dunia digital saat ini.

Apa itu Hadoop?

Hadoop adalah sebuah framework sumber terbuka yang dirancang untuk menyimpan dan memproses data besar dengan efisien. Teknologi ini banyak digunakan oleh perusahaan besar untuk memproses data dalam jumlah besar.

Dikembangkan oleh Google dan Apache Software Foundation, Hadoop bertujuan untuk mempermudah pekerjaan analis data di berbagai sektor. Hadoop juga sering disebut sebagai Apache Hadoop.

Teknologi ini memungkinkan pemrosesan data secara terdistribusi di berbagai komputer atau node yang terhubung dalam sebuah kluster. Dengan begitu, Hadoop dapat memproses data dalam ukuran besar secara efisien dan mempercepat proses pemrosesan data itu sendiri.

Framework ini mampu menyimpan dataset yang ukurannya mulai dari gigabyte hingga petabyte. Hadoop dikembangkan untuk mengatasi masalah yang dihadapi oleh metode pemrosesan data besar tradisional, khususnya dalam menangani data yang heterogen seperti data terstruktur, tidak terstruktur, dan semi-terstruktur.

Sejarah Hadoop

Sejarah Hadoop berawal dari inspirasi terhadap dua makalah penting milik Google, yaitu MapReduce dan Google File System (GFS) yang dipublikasikan pada Oktober 2003. Makalah tersebut mengungkapkan bagaimana Google mengelola data dalam skala sangat besar dengan pendekatan yang kompleks.

Melihat potensi dari konsep ini, Doug Cutting dan Mike Cafarella mulai mengembangkan Hadoop pada tahun 2005 ketika mereka bekerja di Yahoo. Setahun kemudian, tepatnya pada 2006, Yahoo! memperkenalkan Hadoop secara resmi ke publik.

Nama “Hadoop” sendiri berasal dari nama mainan gajah kuning milik anak Doug Cutting. Awalnya, Google dan Apache Software Foundation menciptakan proyek ini, namun kini pengelolaan penuh Hadoop berada di tangan Apache Software Foundation.

Cara Kerja Hadoop

Hadoop bekerja dengan cara memproses dan menyimpan big data secara terdistribusi. Sistem ini membagi dataset yang sangat besar ke dalam beberapa bagian dan menyebarkannya ke berbagai mesin atau node dalam satu cluster. Setiap node kemudian memproses data secara bersamaan.

Proses paralel ini membuat pengolahan data menjadi lebih cepat dan efisien. Secara keseluruhan, cara kerja Hadoop dimulai dari HDFS yang menyimpan data ke seluruh node dalam cluster, lalu MapReduce yang mengolah data tersebut secara paralel, dengan YARN mengatur pembagian sumber daya agar setiap proses berjalan efisien.

Manfaat Hadoop

Sebelum memutuskan menggunakan Hadoop, penting untuk memahami berbagai manfaat yang ditawarkannya. Berikut penjelasan lengkapnya!

1. Skalabilitas Tinggi

Hadoop dirancang dengan kemampuan skalabilitas yang tinggi. Anda bisa memproses data berukuran sangat besar (bahkan hingga petabyte atau exabyte) dengan menambahkan ribuan node ke dalam satu cluster.

Struktur distributed-nya memungkinkan Anda untuk menambah kapasitas penyimpanan dan pemrosesan hanya dengan menambahkan node baru, tanpa perlu mengubah struktur kode secara besar-besaran. Hal ini membuat Hadoop jauh lebih unggul dibandingkan solusi tradisional dalam hal skala pengolahan data.

2. Efisiensi Biaya

Menggunakan Hadoop memungkinkan Anda menekan biaya operasional. Sistem ini berjalan di atas perangkat keras standar yang lebih terjangkau, bahkan bisa menggunakan perangkat kelas rendah.

Selain itu, karena bersifat open-source dan gratis digunakan, Hadoop memberi solusi pengolahan data yang hemat biaya. Banyak organisasi menggunakannya untuk mengurangi anggaran IT mereka tanpa harus mengorbankan performa.

3. Toleransi terhadap Kegagalan

Hadoop memiliki ketahanan tinggi terhadap kegagalan. Komponen Hadoop Distributed File System (HDFS) dirancang untuk menjaga data tetap aman meski terjadi kerusakan perangkat keras atau lunak.

Data akan direplikasi ke beberapa node, sehingga jika satu node bermasalah, sistem tetap bisa mengambil salinan data dari node lainnya. Arsitektur redundant ini memastikan ketersediaan data yang tinggi dan meminimalkan risiko kehilangan data.

4. Pemrosesan Data Paralel

Dengan Hadoop, Anda bisa memproses data secara paralel. Sistem ini membagi dataset besar ke beberapa mesin atau node dalam satu cluster, lalu memprosesnya secara bersamaan.

Pendekatan ini mempercepat dan meningkatkan efisiensi pengolahan data. MapReduce, sebagai kerangka kerja pemrosesan utama, membagi tugas ke berbagai node untuk dijalankan secara paralel, menjadikan proses lebih cepat dibanding metode konvensional.

5. Dukungan untuk Berbagai Jenis Data

Hadoop mendukung penyimpanan dan pengolahan berbagai jenis data, baik terstruktur, semi-terstruktur, maupun tidak terstruktur. Anda bisa memproses teks, video, log server, hingga format data lainnya tanpa batasan.

Kemampuan ini sangat membantu dalam menangani data dari berbagai sumber dengan format yang berbeda-beda, yang seringkali menjadi tantangan dalam sistem pengolahan data tradisional.

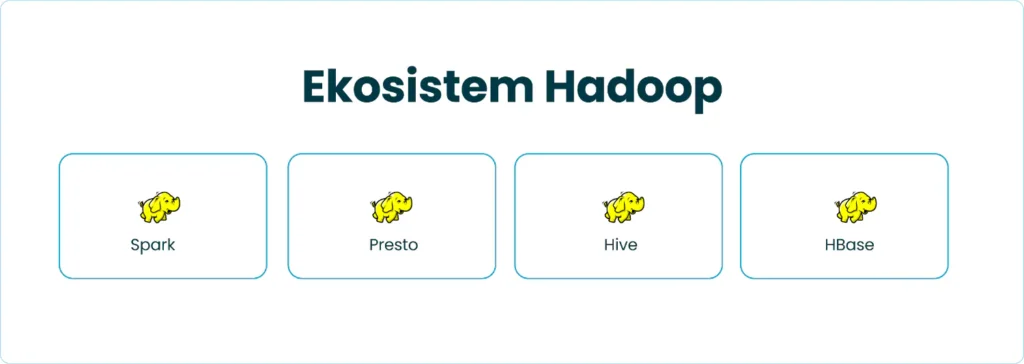

Ekosistem Hadoop

Ekosistem Hadoop menyediakan berbagai tools untuk mengumpulkan, menyimpan, menganalisis, dan mengelola big data. Di bawah ini, Anda akan mengenal empat komponen penting dalam ekosistem ini:

1. Spark

Anda bisa mengandalkan Spark untuk memproses data secara terdistribusi dan cepat. Alat ini bersifat open source dan dirancang khusus untuk mengolah big data dalam berbagai bentuk.

Dengan Spark, Anda bisa menjalankan batch processing, streaming analytics, hingga tugas machine learning dan operasi basis data graf. Karena kecepatannya, banyak perusahaan memanfaatkan Spark untuk pemrosesan real-time. Bahkan, saat digunakan bersama Hadoop, Spark mampu bekerja lebih cepat dibandingkan MapReduce.

2. Presto

Jika Anda membutuhkan analisis data secara interaktif dengan respons cepat, Presto bisa menjadi pilihan tepat. Presto merupakan distributed SQL query engine yang juga bersifat open source.

Anda bisa menggunakannya untuk menjalankan kueri kompleks terhadap data dari berbagai sumber, seperti HDFS dan Amazon S3. Di lingkungan Hadoop, Presto sering digunakan untuk menganalisis data secara ad hoc dengan latensi rendah.

3. Hive

Hive memudahkan Anda dalam mengakses dan menganalisis data besar menggunakan sintaks mirip SQL yang disebut HiveQL. Alat ini berfungsi sebagai data warehouse di dalam ekosistem Hadoop, dan memungkinkan integrasi langsung dengan HDFS.

Biasanya, Hive digunakan untuk menerjemahkan kueri HiveQL ke dalam proses MapReduce, menjadikannya cocok untuk analisis data skala besar.

4. HBase

Untuk kebutuhan akses cepat ke data dalam jumlah besar, Anda bisa menggunakan HBase. Berbeda dari Hive, HBase adalah basis data non-relasional yang dirancang untuk menangani tabel dengan jutaan hingga miliaran baris.

Alat ini bekerja baik bersama HDFS dan Amazon S3, serta memberikan fleksibilitas tinggi untuk membaca dan menulis data dengan cepat di lingkungan Hadoop.

Modul Utama dalam Framework Hadoop

Untuk menjalankan proses penyimpanan dan pengolahan big data secara efisien, Hadoop mengandalkan empat modul utama. Setiap modul memiliki peran penting yang saling melengkapi agar sistem berjalan optimal. Mari kita bahas satu per satu.

1. Hadoop Distributed File System (HDFS)

HDFS berfungsi sebagai sistem file terdistribusi dalam Hadoop. Modul ini membagi data berukuran besar menjadi blok-blok kecil, lalu menyebarkannya ke berbagai node dalam cluster untuk disimpan. Sistem ini dapat berjalan di perangkat keras standar, bahkan di perangkat dengan spesifikasi rendah.

Salah satu fitur utamanya adalah kemampuan untuk mereplikasi data ke beberapa node, sehingga jika ada kegagalan pada satu atau lebih node, salinan data tetap tersedia. Dengan cara ini, HDFS memastikan data tetap aman dan sistem tetap tangguh.

2. MapReduce

MapReduce merupakan model pemrograman yang Hadoop gunakan untuk memproses data yang tersimpan di HDFS. Prosesnya berjalan secara paralel, di mana setiap tugas dibagi ke beberapa node. Tahap pertama, Map, memecah data menjadi bagian kecil dan memprosesnya secara terpisah.

Selanjutnya, tahap Reduce menggabungkan hasil-hasil tersebut untuk membentuk output akhir. Dengan metode ini, Hadoop dapat menangani volume data besar secara efisien.

3. YARN (Yet Another Resource Negotiator)

YARN bertindak sebagai pengelola sumber daya dalam sistem Hadoop. Modul ini mengatur dan memantau penggunaan CPU dan memori agar aplikasi yang berjalan mendapatkan sumber daya yang cukup.

YARN juga memastikan pembagian tugas berjalan seimbang di seluruh node, serta memungkinkan berbagai jenis aplikasi pengolahan data berjalan bersamaan dalam satu cluster tanpa gangguan. Dengan kata lain, YARN menjaga agar sistem tetap optimal.

4. Hadoop Common

Modul ini menyediakan kumpulan pustaka dan utilitas yang diperlukan oleh ketiga modul lainnya. Hadoop Common berisi Java libraries dan komponen dasar yang memungkinkan setiap bagian Hadoop berfungsi secara konsisten. Tanpa modul ini, komponen seperti HDFS, MapReduce, dan YARN tidak akan bisa beroperasi sebagaimana mestinya.

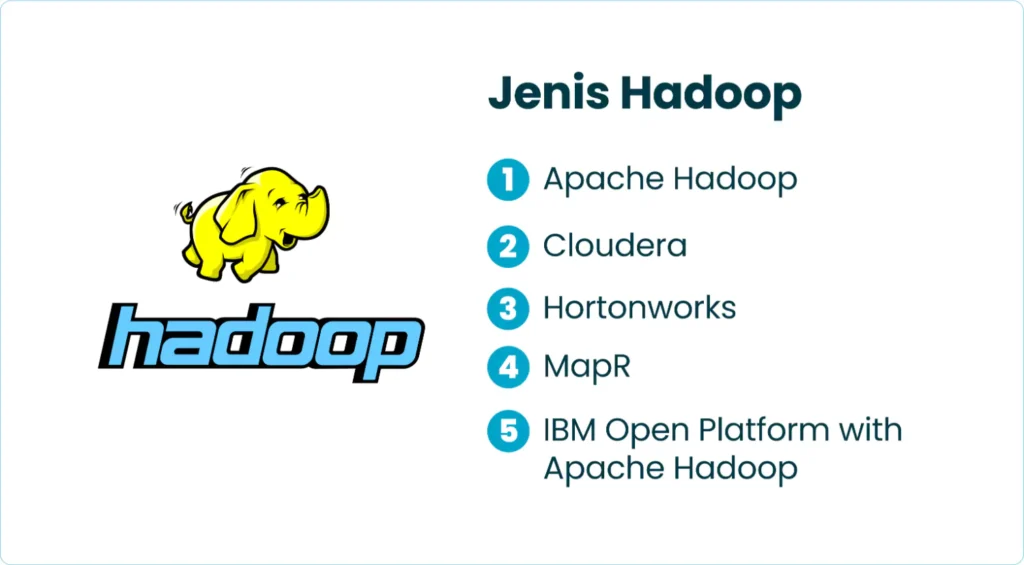

Jenis Hadoop

Masing-masing jenis di bawah ini menawarkan fitur, alat manajemen, dan fokus yang berbeda-beda.

1. Apache Hadoop

Apache Hadoop merupakan distribusi resmi yang dikembangkan oleh Apache Software Foundation. Distribusi ini menyediakan komponen inti seperti HDFS (Hadoop Distributed File System) dan MapReduce. Selain itu, Anda juga bisa menggunakan alat bantu seperti Hive, Pig, dan Spark untuk kebutuhan analisis data yang lebih kompleks.

2. Cloudera

Cloudera dikenal sebagai salah satu distribusi Hadoop paling populer. Distribusi ini sudah dikonfigurasi agar mudah digunakan dan dilengkapi dengan berbagai alat tambahan seperti Cloudera Manager, Impala, dan Search untuk meningkatkan efisiensi pengelolaan dan pencarian data.

3. Hortonworks

Hortonworks fokus pada pengembangan platform Hadoop dengan menyediakan distribusi lengkap serta layanan konsultasi untuk implementasi di dalam perusahaan. Dengan pendekatan ini, Hortonworks membantu organisasi membangun sistem pengelolaan data yang terintegrasi dan dapat diskalakan.

4. MapR

MapR mengedepankan kinerja tinggi dan keamanan data. Alih-alih menggunakan HDFS, MapR mengembangkan sistem file sendiri yang disebut MapR-FS, yang diklaim lebih cepat dan aman. Selain itu, mereka juga menyediakan alat tambahan seperti MapR-DB dan MapR Streams untuk analisis data secara real-time.

5. IBM Open Platform with Apache Hadoop

Distribusi ini dikembangkan oleh IBM dengan tetap mengacu pada Apache Hadoop. IBM menyertakan alat-alat tambahan seperti BigInsights dan Analytics for Apache Hadoop yang mendukung analisis data skala besar dan pengelolaan Hadoop yang lebih mudah.

Contoh Penggunaan Hadoop

Berbagai industri telah memanfaatkan Hadoop untuk mengelola, memproses, dan menganalisis data dalam skala besar dan kompleks. Berikut ini beberapa contoh penerapan Hadoop di berbagai sektor.

1. Industri Keuangan

Perusahaan keuangan menggunakan Hadoop untuk mengelola data transaksi historis dan finansial secara menyeluruh. Dengan kemampuannya, mereka dapat menganalisis risiko kredit dengan lebih akurat, mendeteksi penipuan secara efisien, dan mengelola risiko secara lebih efektif.

Bank memanfaatkan Hadoop untuk menganalisis data transaksi nasabah dalam jumlah besar, mendeteksi pola transaksi mencurigakan, serta memantau risiko penipuan secara real-time. Hasilnya, keamanan dan kepatuhan terhadap regulasi semakin meningkat.

2. E-commerce

Perusahaan e-commerce mengandalkannya untuk memproses data pelanggan seperti riwayat pembelian, preferensi produk, dan geografis. Dengan analisis dari data tersebut, mereka dapat memahami perilaku belanja pelanggan, menyusun strategi pemasaran yang lebih tepat sasaran, dan memberikan rekomendasi produk yang lebih personal.

3. Telekomunikasi

Perusahaan telekomunikasi memproses data dari jutaan pelanggan menggunakan Hadoop. Mereka menganalisis pola penggunaan layanan, kondisi jaringan, dan data geografis untuk memahami kebutuhan pelanggan serta mengoptimalkan kinerja jaringan.

4. Kesehatan

Rumah sakit dan lembaga kesehatan memanfaatkan Hadoop untuk mengolah data medis seperti data pasien, hasil klinis, dan penelitian. Dengan analisis ini, mereka dapat mengenali tren kesehatan, menegakkan diagnosis secara lebih tepat, dan menyusun rencana perawatan yang lebih efektif.

Selain itu, lembaga riset medis dan farmasi menggunakan Hadoop untuk menganalisis data genomik manusia, mempercepat penemuan pola genetik, dan mengembangkan obat serta terapi yang lebih tepat sasaran.

5. Pemerintah

Instansi pemerintah mengintegrasikan Hadoop untuk mengelola berbagai jenis data, mulai dari data demografi, keamanan, hingga kesehatan publik. Mereka memanfaatkan kemampuannya untuk menyatukan data dari banyak sumber, lalu menganalisisnya demi memahami dinamika penduduk, status keamanan nasional, dan kondisi kesehatan.

Dengan analisis ini, pemerintah dapat menyusun kebijakan publik yang lebih efektif, mengalokasikan sumber daya dengan tepat, dan merespons situasi darurat dengan cepat. Lembaga meteorologi, misalnya, memakai Hadoop untuk menganalisis data sensor cuaca dari seluruh dunia, memprediksi badai, serta memantau perubahan iklim.

Hadoop untuk Pengolahan Big Data yang Lebih Efektif

Hadoop adalah hal penting dalam pengelolaan big data modern. Fungsinya telah menjadi membantu banyak perusahaan yang ingin mengoptimalkan data mereka. Melalui modul-modul utamanya dukungan dari ekosistem yang luas seperti menghadirkan solusi lengkap untuk berbagai kebutuhan data, dari penyimpanan hingga analitik.

Meskipun masih memiliki tantangan, manfaat skalabilitas, efisiensi biaya, toleransi terhadap kegagalan menjadikan Hadoop solusi yang layak dipertimbangkan dalam era data digital saat ini. Jika digunakan secara tepat, Hadoop tidak hanya menjadi alat teknis, tetapi juga penggerak inovasi dalam pengambilan keputusan berbasis data.

FAQ (Frequently Asked Question)

Mengapa arsitektur Hadoop lebih cocok untuk analisis batch dibandingkan analisis real-time?

Hadoop dirancang dengan pendekatan batch-processing, di mana data disimpan dalam jumlah besar dan diproses secara periodik dalam batch besar. MapReduce, sebagai engine default-nya, bekerja secara sekuensial dengan membaca data dari disk, memproses, lalu menuliskannya kembali, yang membuatnya lambat untuk kebutuhan real-time. Sistem ini sangat efisien untuk analisis data historis atau agregat besar, tetapi tidak dirancang untuk memberikan hasil dalam hitungan detik seperti sistem streaming data.

Bagaimana HDFS menangani masalah data corruption dalam skenario node failure?

HDFS (Hadoop Distributed File System) secara default menyimpan setiap blok data dalam tiga salinan (replication factor = 3) di node yang berbeda. Ketika satu node gagal atau terjadi korupsi, NameNode akan secara otomatis mengarahkan pembacaan ke salinan lain yang masih utuh. Jika jumlah salinan menurun, sistem secara otomatis mereplikasi ulang blok tersebut untuk menjaga ketahanan data, menjadikan HDFS sangat toleran terhadap kegagalan perangkat keras.

Apa tantangan tersembunyi saat melakukan migrasi data dari sistem RDBMS tradisional ke Hadoop?

Migrasi dari RDBMS ke Hadoop sering kali terhambat oleh perbedaan fundamental dalam struktur data. Data dalam RDBMS sangat terstruktur dan bergantung pada skema yang ketat, sedangkan Hadoop lebih fleksibel dan menerima data semi-terstruktur atau tidak terstruktur. Tantangan muncul ketika relasi antar tabel harus dipetakan ulang, integritas data harus dijaga tanpa constraint eksplisit, dan pipeline transformasi harus disesuaikan agar berjalan optimal di MapReduce atau Hive.

Dalam konteks keamanan data, mengapa Hadoop dianggap kurang aman secara default?

Secara default, Hadoop tidak dilengkapi dengan sistem autentikasi yang ketat maupun enkripsi data. Hadoop awalnya dibangun untuk lingkungan yang dipercaya secara internal, sehingga fitur keamanan seperti Kerberos, ACL, enkripsi di HDFS, dan audit trail perlu dikonfigurasi secara manual. Tanpa pengamanan tambahan ini, Hadoop rentan terhadap akses tidak sah dan kebocoran data, terutama dalam cluster yang dibuka untuk banyak pengguna.

Apa tantangan performa yang muncul saat menjalankan query kompleks di Hive, dan bagaimana mengatasinya?

Hive menerjemahkan query SQL ke dalam job MapReduce, yang sering kali membuat eksekusi query menjadi lambat, terutama jika terdapat banyak join, subquery, atau agregasi kompleks. Untuk mengatasi ini, banyak pengguna beralih ke engine seperti Tez, Spark, atau bahkan Presto, yang menawarkan eksekusi in-memory yang jauh lebih cepat. Selain itu, optimalisasi partisi, bucketing, dan indexing di Hive dapat membantu meningkatkan performa query secara signifikan.

Bagaimana perusahaan besar mengintegrasikan Hadoop ke dalam arsitektur data lake mereka?

Dalam arsitektur data lake, Hadoop biasanya berfungsi sebagai storage dan processing layer untuk data mentah. Data dari berbagai sumber disimpan di HDFS, lalu diproses dengan MapReduce, Spark, atau Hive, sebelum dikonsumsi oleh sistem downstream seperti warehouse (Snowflake, Redshift) atau tool BI. Dengan integrasi menggunakan tools seperti Sqoop, Flume, dan Kafka, data dapat mengalir secara seamless antara Hadoop dan sistem lain dalam pipeline.

Apa risiko tersembunyi dari over-partitioning saat menggunakan Hive di atas Hadoop?

Over-partitioning, atau membuat terlalu banyak partisi dalam satu tabel Hive, dapat menyebabkan eksplosifnya jumlah metadata yang harus dikelola oleh Hive metastore. Ini memperlambat eksekusi query karena Hive harus memeriksa banyak direktori meski hanya sebagian kecil yang relevan. Akibatnya, performa justru menurun, terutama untuk query dengan filter yang lemah. Strategi yang bijak dalam mendesain partisi sangat penting untuk menjaga performa tetap optimal.

Mengapa Hadoop jarang digunakan untuk penyimpanan file kecil dan bagaimana solusi terbaik untuk masalah ini?

Hadoop HDFS tidak efisien untuk file kecil karena setiap file dan blok metadata harus dilacak oleh NameNode, yang menyimpan semuanya di memori. Jika terdapat jutaan file kecil, ini bisa menyebabkan kelebihan beban pada NameNode. Solusinya adalah dengan menggabungkan file-file kecil ke dalam container besar menggunakan SequenceFile, HAR (Hadoop Archive), atau menggunakan sistem seperti HBase untuk menyimpan data granular.

Dalam praktiknya, bagaimana organisasi mengelola resource cluster Hadoop untuk mencegah job saling mengganggu?

YARN (Yet Another Resource Negotiator) adalah komponen Hadoop yang bertugas mengelola resource dan alokasi job. Dengan pengaturan queue, limit CPU/memory, dan policy berdasarkan user atau grup, YARN memungkinkan pembagian resource secara adil. Banyak perusahaan juga menggunakan tool seperti Apache Ranger untuk kontrol akses dan Apache Ambari untuk monitoring dan manajemen cluster secara visual.

Bagaimana masa depan Hadoop di tengah naiknya popularitas cloud-native dan teknologi seperti Snowflake atau Databricks?

Hadoop saat ini tidak lagi dianggap sebagai solusi modern untuk semua jenis data workload. Banyak organisasi mulai beralih ke platform cloud-native yang lebih fleksibel dan mudah diatur, seperti Snowflake, BigQuery, atau Databricks. Namun, Hadoop tetap relevan untuk perusahaan dengan investasi besar pada on-premise infrastructure, terutama sebagai penyimpanan data lake yang murah dan skalabel. Evolusi Hadoop juga terus berlangsung melalui adaptasi dengan Spark, containerization, dan integrasi dengan cloud platform seperti AWS EMR atau Azure HDInsight.