Data engineer adalah salah satu profesi yang kini banyak dibutuhkan di era digital yang serba data. Anda akan menemukan bagaimana peran ini menjadi kunci dalam mengelola, memproses, dan menyiapkan data agar bisa digunakan perusahaan untuk pengambilan keputusan.

Artikel ini akan mengupas skill yang wajib dikuasai, tugas harian yang dijalani, serta tanggung jawab besar yang dipikul seorang data engineer. Anda juga akan memahami kenapa profesi ini sangat dicari di berbagai industri dan bagaimana peluang kariernya terus tumbuh.

Apa Itu Data Engineer?

Data engineer adalah seorang profesional yang bertugas merancang, membangun, dan memelihara infrastruktur serta sistem yang dibutuhkan untuk mengumpulkan, memproses, mengelola, dan menyimpan data dari berbagai sumber dalam sebuah organisasi.

Anda akan melihat bagaimana mereka membangun sistem yang memastikan data bisa digunakan dengan mudah dan cepat oleh data analyst, data scientist, dan business analyst. Mereka memastikan data yang dikumpulkan selalu akurat, andal, konsisten, dan tersedia dalam format yang tepat.

Mereka aktif mengubah raw data yang kompleks dan tidak terstruktur menjadi format yang rapi dan siap untuk dianalisis. Dalam pekerjaannya, mereka membangun dan mengelola berbagai sistem seperti database, data warehouse, pipeline, dan sistem lain yang mampu menangani serta memproses big data.

Mereka juga mengoptimalkan arsitektur data dan pipeline agar proses pengiriman data berjalan lebih efisien. Banyak orang juga menyebut mereka sebagai software engineer yang berfokus pada persiapan data melalui pembangunan sistem dan infrastruktur.

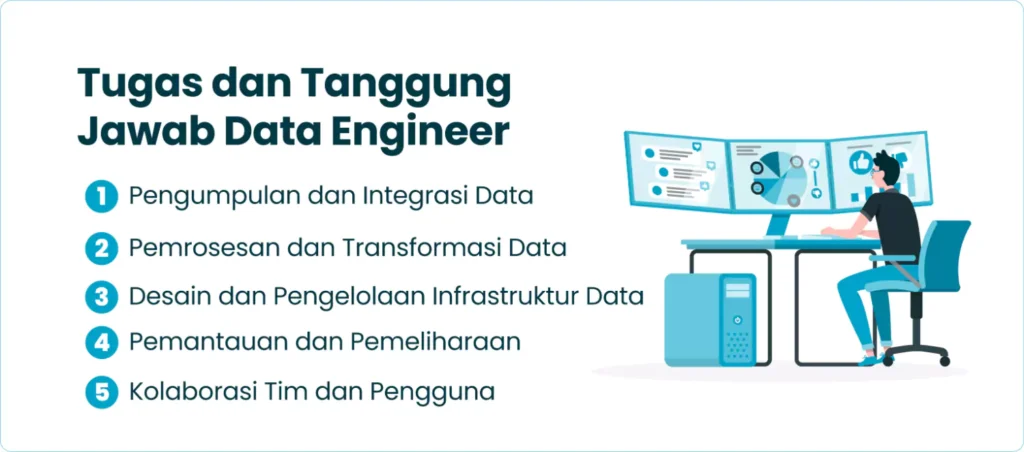

Tugas dan Tanggung Jawab Data Engineer

Seorang data engineer bertugas merancang, membangun, dan memelihara sistem serta infrastruktur yang dibutuhkan untuk menangani data dalam suatu organisasi. Berikut penjelasan lengkap tugas dan tanggung jawabnya.

1. Pengumpulan dan Integrasi Data

Data engineer mengumpulkan data dari berbagai sumber seperti internal database, sumber eksternal, API, atau alat lainnya. Mereka memastikan data yang dikumpulkan relevan dengan kebutuhan bisnis. Mereka mengekstrak data dari sumber seperti basis data, file teks, atau API, lalu mengintegrasikan data yang terpisah agar menjadi satu kesatuan yang utuh.

Selama proses ini, mereka memastikan pengumpulan data sesuai dengan kebijakan keamanan dan terus meningkatkan kualitas serta efisiensi pengumpulan data. Mereka juga memilah dan menyaring data agar lebih mudah digunakan.

2. Pemrosesan dan Transformasi Data

Setelah data terkumpul, data engineer memproses dan mentransformasi data agar sesuai dengan kebutuhan bisnis. Mereka membersihkan data, mengubah format dan strukturnya, serta menyederhanakan raw data yang kompleks menjadi format terstruktur yang siap dianalisis.

Dalam proses ETL (Extract, Transform, Load), mereka menyaring, menggabungkan, menghapus duplikasi, memvalidasi, dan mengautentikasi data. Selain itu, mereka melakukan perhitungan, menerjemahkan atau meringkas data, mengubah format teks, atau mengonversi mata uang.

3. Desain dan Pengelolaan Infrastruktur Data

Data engineer merancang, membangun, dan memelihara infrastruktur yang dibutuhkan untuk mengelola serta menyimpan data. Mereka membangun sistem yang mampu menangani data dalam skala besar, termasuk ribuan hingga jutaan permintaan per menit. Infrastruktur ini meliputi database, data warehouse, data lake, pipeline, dan sistem lainnya.

Mereka memilih dan mengonfigurasi sistem database dan alat ETL, membangun, menguji, serta memelihara pipeline yang efisien. Selain itu, mereka mengoptimalkan arsitektur data agar proses pengiriman data lebih cepat dan efisien.

Mereka juga memuat data ke dalam data warehouse dengan proses full load atau incremental load, memastikan data tersedia dalam format yang benar, akurat, aman, dan selalu bisa diakses.

4. Pemantauan dan Pemeliharaan

Data engineer memantau kinerja sistem data yang mereka bangun. Mereka mengidentifikasi dan memperbaiki masalah yang muncul, melakukan pemeliharaan rutin pada infrastruktur data, dan mengambil langkah pencegahan untuk menghindari kegagalan sistem.

Mereka menjaga integritas data dan memastikan pipeline serta infrastruktur data tetap berjalan dengan baik dalam jangka panjang.

5. Kolaborasi Tim dan Pengguna

Data engineer bekerja sama dengan data scientist, data analyst, dan pengguna bisnis untuk memahami kebutuhan data mereka. Mereka merancang solusi berbasis data bersama tim dan berkoordinasi dengan manajemen agar selaras dengan tujuan bisnis perusahaan.

Mereka berkomunikasi secara efektif dengan para pemangku kepentingan, termasuk pihak non-teknis, untuk menjelaskan konsep yang rumit atau perkembangan proyek. Sesekali, mereka juga mempresentasikan hasil analisis atau pemrosesan data yang telah dilakukan.

Skill yang Harus Dimiliki Seorang Data Engineer

Meskipun lulusan IT, matematika, atau statistik sering menjadi kandidat utama, siapa saja yang memiliki kemampuan dan minat di bidang data bisa meniti karier ini. Berikut ini keterampilan yang wajib Anda kuasai jika ingin sukses sebagai data engineer.

1. SQL dan Python

Anda harus menguasai SQL (Structured Query Language) dan Python sebagai keterampilan teknis utama. Dengan SQL, Anda dapat mengakses, mengambil, menjalankan query, dan menghapus data dalam database.

Selain itu, Anda perlu mahir menggunakan Python untuk mengembangkan website, software, melakukan system scripting, dan mengelola data. Python juga sering digunakan dalam analisis data dan pengembangan model machine learning. Bahasa pemrograman lain seperti Scala atau Java akan memperkuat kemampuan Anda.

2. Teknologi cloud platforms

Anda perlu memahami teknologi cloud computing karena teknologi ini memungkinkan penyimpanan dan akses data dari mana saja. Penguasaan cloud platforms seperti Amazon Web Services (AWS), Google Cloud Platform (GCP), atau Microsoft Azure sangat penting untuk membangun dan mengelola infrastruktur data.

Anda juga harus familiar dengan layanan seperti Amazon S3, Amazon Redshift, Google BigQuery, dan Azure Data Lake Storage yang digunakan untuk menyimpan dan menganalisis data.

3. Pengetahuan di bidang system scripting

Anda harus bisa menggunakan bahasa scripting untuk menerjemahkan kode atau perintah dalam sistem. Dengan scripting, Anda dapat membuat data lebih mudah dibaca dan diproses oleh manajer data. Penguasaan system scripting menjadi bekal penting dalam mendukung pekerjaan harian.

4. Pemahaman operating system

Anda perlu memahami berbagai operating system karena setiap sistem menawarkan fitur dan keunggulan yang berbeda. Pemahaman ini akan membantu Anda memilih sistem operasi yang paling sesuai dengan kebutuhan bisnis dan proyek data yang Anda kelola.

5. Analisis data

Anda harus mampu menggunakan perangkat analytics software seperti MapReduce, Hive, Pig, dan HBase. Keterampilan analisis data membantu Anda membangun dan meningkatkan sistem pengelolaan data.

Meskipun biasanya menjadi fokus data scientist, kemampuan analisis tetap penting bagi seorang data engineer dalam memahami data dan melakukan analisis statistik.

6. Data warehousing

Anda harus menguasai konsep data warehousing karena Anda akan bertanggung jawab menyimpan dan menganalisis data dalam jumlah besar. Pengetahuan tentang solusi seperti Panoply atau Amazon Redshift penting dalam membangun sistem data warehouse.

Data yang diproses biasanya disimpan dalam data warehouse atau data lake dengan teknologi seperti Hadoop.

7. Berpikir kritis

Anda perlu memiliki keterampilan berpikir kritis untuk menemukan solusi efektif atas berbagai masalah yang muncul. Kemampuan ini sangat penting dalam merancang sistem dan mengumpulkan data, sekaligus mendukung proses problem solving di berbagai situasi.

8. Dasar-dasar machine learning

Anda perlu memahami dasar-dasar machine learning agar bisa membangun model data dan melakukan analisis statistik. Meski pengembangan model machine learning lebih banyak dilakukan data scientist, Anda akan berperan dalam mengintegrasikan model tersebut ke dalam platform dan memantau performanya.

9. Komunikasi

Anda harus memiliki keterampilan komunikasi yang baik karena Anda akan berinteraksi dengan banyak orang, termasuk rekan kerja non-teknis. Komunikasi yang efektif memudahkan Anda menjelaskan progres dan tantangan dalam proyek sehingga kolaborasi berjalan lancar.

10. Public speaking

Anda juga perlu memiliki kemampuan public speaking. Seorang data engineer sering diminta mempresentasikan hasil kerja mereka. Keterampilan ini akan membantu Anda menyampaikan ide dan hasil dengan percaya diri serta meyakinkan rekan kerja atau pemangku kepentingan lainnya.

Tools yang Digunakan Seorang Data Engineer

Dalam pekerjaan sehari-hari, seorang data engineer mengandalkan berbagai tools untuk mengumpulkan, memproses, menyimpan, dan menganalisis data. Tools ini agar perusahaan bisa memanfaatkan data secara optimal.

1. Apache Spark

Seorang data engineer menggunakan Apache Spark untuk memproses data dalam jumlah besar dengan cepat dan skala luas. Tool ini berfungsi sebagai data processing framework yang mendukung big data processing dan analisis secara real-time. Mereka juga memanfaatkannya untuk menjalankan ETL (Extract, Transform, Load) lebih fleksibel.

2. Apache Kafka

Dengan Apache Kafka, data engineer bisa mengumpulkan, mengirim, dan memproses data secara langsung saat data itu masuk (real-time). Tool ini berperan penting dalam membangun data pipeline yang menangani arus data besar secara cepat. Misalnya, bisnis e-commerce, mereka memakai Kafka untuk mengelola data stream pelanggan langsung.

3. Apache Hadoop

Data engineer memanfaatkan Apache Hadoop untuk menyimpan dan memproses data dalam skala besar melalui sistem distributed. Dengan framework ini, mereka bisa mengelola penyimpanan dan pemrosesan data di data warehouse atau data lake dengan efisien.

4. Apache Airflow

Saat mengatur dan menjadwalkan proses ETL, data engineer menggunakan Apache Airflow. Tool ini membantu mereka mengelola alur kerja (workflow) dalam data pipeline. Dengan Airflow, mereka bisa mengatur, menjadwalkan, dan memantau jalannya proses data agar tetap terorganisasi dengan baik.

5. AWS/GCP/Azure

Data engineer memanfaatkan platform cloud computing seperti Amazon Web Services (AWS), Google Cloud Platform (GCP), dan Microsoft Azure untuk membangun dan mengelola infrastruktur data di lingkungan cloud.

Mereka memakai layanan seperti Amazon S3, Amazon Redshift, Google BigQuery, atau Azure Data Lake Storage untuk menyimpan, mengolah, dan menganalisis data skala besar. Penguasaan platform ini penting saat mereka menangani proyek data modern.

6. SQL Databases

Untuk mengelola data terstruktur, data engineer bekerja dengan SQL databases seperti PostgreSQL, MySQL, atau Oracle. Mereka menggunakan SQL (Structured Query Language) untuk mengakses dan mengambil data dalam relational database. Tool ini membantu mereka menyimpan dan mengelola data yang terorganisasi dalam bentuk tabel dengan efisien.

7. NoSQL Databases

Saat harus mengelola data semi-terstruktur atau tidak terstruktur, data engineer memakai NoSQL databases seperti MongoDB, Cassandra, atau Redis. Dengan database ini, mereka bisa menyimpan dan mengatur data yang tidak selalu berbentuk tabel, misalnya document database seperti MongoDB. Penguasaan NoSQL penting ketika mereka bekerja dengan data dalam format yang lebih fleksibel.

Baca Juga : Apa itu Cyber Security Analyst? Tugas, Skill, dan Gajinya

Prospek Karier Data Engineer

Profesi data engineer menawarkan prospek karier yang menjanjikan dan terus dibutuhkan di era digital. Perusahaan semakin menyadari bahwa data merupakan aset berharga yang mendorong keputusan bisnis yang tepat. Karena itu, mereka aktif mencari tenaga ahli yang mampu mengelola, memproses, dan mengintegrasikan data secara efektif.

Permintaan terhadap data engineer tergolong tinggi. Di Indonesia, profesi ini sering disebut sebagai salah satu pekerjaan yang paling dicari di sektor IT. Tidak hanya perusahaan teknologi yang membutuhkannya; sektor lain seperti perbankan yang tengah beralih ke teknologi digital juga membuka peluang yang luas.

Lulusan IT yang memilih jalur ini akan menghadapi masa depan yang cerah. Pekerjaan ini tidak hanya relevan tetapi juga menawarkan kestabilan dan pertumbuhan. Dari segi penghasilan, gaji data engineer di Indonesia bervariasi tergantung pengalaman.

Kisaran gaji mereka antara Rp8.300.000 hingga Rp16.800.000. Sementara itu, menunjukkan rentang Rp4.100.000 hingga Rp12.000.000. Rata-rata, seorang data engineer bisa mendapatkan sekitar Rp11.000.000 per bulan.

Untuk level pemula atau junior, gaji biasanya berkisar Rp4.000.000 hingga Rp6.000.000 dan akan meningkat seiring bertambahnya pengalaman dan kinerja. Karier data engineer juga menyediakan jalur pengembangan yang jelas.

Anda bisa berkembang melalui tahapan berikut:

- Junior Data Engineer – bekerja dengan supervisi

- Data Engineer Officer – bekerja mandiri tanpa supervisi

- Senior Data Engineer – memimpin tim, merencanakan infrastruktur, dan melakukan evaluasi

- Chief Data Officer – memimpin tim Data Analyst, Data Engineer, dan Data Manager

Dengan semakin besarnya volume dan nilai data, peran data engineer akan terus dibutuhkan untuk memastikan data siap diolah dan dimanfaatkan demi pengambilan keputusan bisnis yang lebih baik.

Data Engineer vs Data Scientist

Ketika Anda memasuki dunia big data, Anda akan menemukan dua peran yang sering disandingkan: Data Engineer dan Data Scientist. Keduanya sama-sama penting, namun memiliki fokus dan tanggung jawab yang berbeda. Agar Anda memahami perbedaan perannya, mari kita bahas secara rinci.

1. Data Engineer

Sebagai bagian dari tim data, Data Engineer berperan dalam membangun fondasi yang kokoh agar data siap digunakan.

a. Fokus Tugas

Data Engineer merancang, membangun, dan mengelola infrastruktur untuk mengolah data dalam skala besar. Mereka mengumpulkan data dari berbagai sumber, membersihkannya, mengubah formatnya, lalu menyimpannya dalam sistem yang aman dan efisien seperti database atau data warehouse.

Mereka membangun data pipeline untuk mengalirkan data mentah menjadi data yang terstruktur dan siap analisis. Tugas mereka juga meliputi konfigurasi sistem ETL (Extract, Transform, Load), pemeliharaan sistem, pemantauan performa, serta memastikan integritas dan keamanan data.

Mereka berkolaborasi dengan Data Scientist dan tim bisnis agar data yang disiapkan sesuai kebutuhan perusahaan. Intinya, mereka mempersiapkan “lapangan” agar data bisa langsung digunakan.

b. Keterampilan Utama

Untuk menjalankan tugasnya, Data Engineer menguasai berbagai alat dan teknologi. Mereka mahir menggunakan SQL, Python, serta sistem ETL seperti Apache Spark, Kafka, dan NiFi. Mereka memahami konsep database, baik relasional seperti PostgreSQL dan MySQL, maupun NoSQL seperti MongoDB dan Cassandra.

Mereka menguasai sistem terdistribusi seperti Hadoop dan alat penyimpanan seperti HDFS, Hive, atau HBase. Penguasaan platform cloud seperti AWS, Google Cloud Platform, atau Microsoft Azure juga menjadi nilai tambah.

Selain keterampilan teknis, mereka perlu memiliki kemampuan berpikir kritis, kolaborasi, dan komunikasi yang baik karena sering berinteraksi dengan berbagai tim.

c. Tujuan Utama

Tujuan utama Data Engineer adalah memastikan data yang dikumpulkan akurat, andal, dan mudah diakses oleh Data Scientist dan analis bisnis. Dengan infrastruktur yang mereka bangun, perusahaan dapat mengambil keputusan berdasarkan data yang valid dan terstruktur.

2. Data Scientist

Setelah infrastruktur data tersedia, giliran Data Scientist yang memanfaatkan data tersebut untuk menemukan wawasan berharga.

a. Fokus Tugas

Data Scientist menggunakan metode ilmiah, algoritma, dan sistem untuk menganalisis dan mengekstrak nilai dari data. Mereka membangun model matematika abstrak untuk membuat prediksi dan menerapkannya dalam produk atau keputusan bisnis.

Mereka menganalisis data yang sudah disiapkan Data Engineer guna mengidentifikasi pola, tren, dan wawasan bisnis yang berguna. Selain itu, mereka mengembangkan model machine learning yang membantu perusahaan dalam pengambilan keputusan.

b. Keterampilan Utama

Data Scientist harus menguasai statistik, matematika, predictive modelling, dan algoritma mesin. Mereka biasanya menggunakan bahasa pemrograman seperti Python atau R, serta alat analisis data seperti TensorFlow atau scikit-learn.

c. Tujuan Utama

Tujuan utama Data Scientist adalah menghasilkan informasi berharga dan prediksi dari data yang sudah siap pakai. Mereka membantu perusahaan mengambil keputusan berdasarkan pemahaman mendalam terhadap data yang dimiliki.

Data Engineer untuk Pengelolaan Data di Era Digital

Data engineer adalah pekerjaan penting yang memastikan data perusahaan dapat dimanfaatkan secara optimal untuk pengambilan keputusan yang tepat. Mereka merancang infrastruktur data, membangun pipeline, hingga memproses dan mengelola data skala besar, profesi ini menjadi penghubung krusial antara teknologi dan kebutuhan bisnis.

Seiring pertumbuhan data yang terus meningkat, permintaan terhadap profesi ini diprediksi akan terus melonjak, membuka peluang karier yang luas bagi Anda yang tertarik menekuni dunia data. Memahami peran, skill, dan tanggung jawab data engineer adalah langkah awal untuk mempersiapkan diri memasuki salah satu bidang paling menjanjikan di era digital ini.

FAQ (Frequently Asked Question)

Bagaimana peran data engineer berubah ketika organisasi beralih dari arsitektur monolitik ke microservices?

Ketika organisasi mengadopsi arsitektur microservices, data engineer menghadapi tantangan baru dalam pengumpulan dan sinkronisasi data karena sumber data menjadi lebih tersebar. Tugas mereka bukan lagi hanya membangun pipeline terpusat, tapi juga mengintegrasikan berbagai stream data secara real-time dari service yang berbeda, mengelola data lineage, dan menjamin konsistensi antar domain. Mereka juga perlu mengadopsi pendekatan event-driven serta tools seperti Kafka atau Pulsar untuk menangani data dalam format yang lebih desentralisasi dan asinkron.

Apa tantangan utama dalam membangun pipeline data real-time dan bagaimana data engineer mengatasinya?

Pipeline real-time menuntut latensi rendah, skalabilitas tinggi, dan toleransi terhadap gangguan. Tantangan utama datang dari kompleksitas integrasi data secara terus-menerus, potensi duplikasi data, dan jaminan delivery. Data engineer mengatasinya dengan menggunakan sistem seperti Apache Kafka, Flink, atau Spark Structured Streaming, serta menerapkan strategi seperti windowing, watermarking, dan exactly-once delivery untuk menjaga integritas dan akurasi data saat bergerak cepat.

Bagaimana data engineer memastikan data quality dalam skala besar tanpa menghambat performa pipeline?

Validasi data dalam volume besar bisa memengaruhi performa jika dilakukan secara agresif. Oleh karena itu, data engineer menerapkan pendekatan modular dengan menyisipkan rule-based validation di tahap awal pipeline (data ingestion) dan anomaly detection di tahap selanjutnya. Mereka juga menggunakan tools seperti Great Expectations atau Deequ untuk menerapkan quality check otomatis tanpa harus menulis skrip manual, sehingga data tetap bersih tanpa mengorbankan efisiensi.

Apa perbedaan pendekatan data engineer dalam membangun pipeline batch dibandingkan stream processing dalam konteks big data?

Dalam pipeline batch, data engineer fokus pada pemrosesan volume besar dalam interval waktu tertentu, biasanya lebih sederhana dan cocok untuk analitik historis. Sedangkan dalam stream processing, pendekatan lebih kompleks karena harus menangani data secara terus-menerus dan dengan latensi rendah. Di sisi teknologi, batch sering melibatkan Hadoop dan Airflow, sedangkan stream membutuhkan ekosistem yang mendukung pemrosesan in-memory dan toleransi terhadap data yang datang out-of-order.

Bagaimana data engineer bekerja sama dengan data scientist untuk menghindari miskomunikasi soal kebutuhan data?

Kolaborasi efektif terjadi saat data engineer terlibat sejak tahap awal perencanaan proyek data science. Mereka harus memahami jenis data dan format yang dibutuhkan, serta ekspektasi frekuensi update-nya. Sebaliknya, data scientist juga perlu memahami keterbatasan teknis dalam mengakses dan membersihkan data. Banyak tim mengandalkan documentasi data catalog dan praktik DataOps untuk menjembatani komunikasi, sehingga data scientist bisa fokus pada eksperimen dan modeling tanpa tersendat oleh masalah data wrangling.

Bagaimana data engineer mengelola versi data (data versioning) dalam lingkungan machine learning yang terus berubah?

Untuk mendukung reproducibility dalam proyek machine learning, data engineer menggunakan data versioning agar setiap eksperimen mengacu pada snapshot data yang konsisten. Mereka memanfaatkan tools seperti DVC atau LakeFS untuk mengelola versi dataset layaknya version control pada kode. Ini memungkinkan tim ML melakukan eksperimen dengan dataset lama tanpa khawatir data telah berubah di pipeline terbaru, serta menjaga transparansi dan audit trail yang dibutuhkan dalam pengembangan model yang akuntabel.

Dalam konteks data governance, apa tanggung jawab data engineer yang paling kritis dan mengapa sering diabaikan?

Salah satu tanggung jawab krusial adalah memastikan metadata dan lineage data terdokumentasi dengan baik. Sayangnya, ini sering diabaikan karena dianggap bukan prioritas teknis. Padahal, tanpa dokumentasi ini, organisasi akan kesulitan melacak asal-usul data, memahami transformasi yang terjadi, dan memenuhi standar kepatuhan seperti GDPR. Data engineer harus berperan aktif dalam menerapkan katalog metadata dan sistem audit yang otomatis agar organisasi bisa menelusuri setiap perubahan data secara historis.

Apa tantangan yang muncul ketika data engineer menangani integrasi data dari sumber legacy dan bagaimana mereka mengatasinya?

Sumber legacy seperti mainframe atau database lama sering kali memiliki struktur data tidak standar, dokumentasi minim, dan sulit diakses secara langsung. Data engineer perlu membangun konektor khusus atau ETL yang kompleks untuk mengekstrak data, dan sering kali harus bekerja sama dengan tim IT lama yang masih memahami struktur tersebut. Mereka juga memanfaatkan alat integrasi modern seperti Talend atau Informatica, serta membuat lapisan staging agar data lama dapat dimodernisasi secara bertahap tanpa mengganggu sistem produksi.

Bagaimana peran data engineer dalam mendukung arsitektur data lakehouse dan mengapa pendekatan ini menjadi relevan?

Dalam arsitektur data lakehouse, data engineer berperan sebagai penghubung antara fleksibilitas data lake dan keandalan data warehouse. Mereka harus memastikan data mentah dari berbagai sumber dapat ditransformasikan dan distandardisasi agar siap digunakan dalam query analitik. Tools seperti Delta Lake atau Apache Iceberg digunakan untuk mengelola transactional layer di atas data lake, sehingga memungkinkan konsistensi data, versioning, dan performa SQL-like yang sebelumnya hanya bisa ditemukan di warehouse tradisional.

Apa indikator bahwa pipeline data yang dibangun oleh data engineer sudah terlalu kompleks dan perlu disederhanakan?

Pipeline yang terlalu kompleks biasanya ditandai oleh banyaknya dependency antar task, sulitnya tracing error, dan waktu eksekusi yang panjang meski hanya menangani data sederhana. Jika proses debugging membutuhkan waktu lebih lama daripada proses eksekusinya sendiri, atau bila perubahan kecil memicu regresi di banyak bagian pipeline, maka itu sinyal untuk refactor. Data engineer sebaiknya memecah pipeline menjadi modul yang terisolasi, memperjelas dokumentasi, dan mengurangi logic transformasi yang tidak esensial.

Baca Juga : Apa itu Cloud Engineer? Tugas dan Skill yang Dibutuhkan