Adversarial Attack merupakan manipulasi data input yang tampak normal bagi manusia, tetapi mampu menipu model AI untuk menghasilkan output yang salah. Serangan ini seringkali memanfaatkan kelemahan algoritma klasifikasi dan neural networks.

Jenis-jenis Adversarial Attack sangat beragam, mulai dari white-box attack yang mengetahui struktur model, hingga black-box attack yang hanya memanfaatkan output. Tujuan utama serangan ini tidak hanya untuk merusak sistem, tetapi juga menguji robustness dan keamanan model dalam kondisi ekstrem. Artikel ini akan membahas secara lengkap definisi, jenis, tujuan, dan contoh dari serangan ini.

Apa itu Adversarial Attack?

Adversarial Attack adalah teknik manipulasi input pada sistem kecerdasan buatan (AI) atau machine learning untuk menipu model agar memberikan hasil yang salah. Input tersebut seringkali terlihat normal di mata manusia.

Namun, model AI dapat salah mengklasifikasikan input tersebut karena adanya gangguan kecil yang sengaja disisipkan. Teknik ini mengeksploitasi kerentanan model dengan memanfaatkan ketidaksempurnaan dalam proses training data dan parameter model.

Adversarial Attack menjadi perhatian besar dalam bidang computer vision, speech recognition, dan aplikasi lainnya yang menggunakan model AI dalam proses pengambilan keputusan.

Sejarah Adversarial Attack

Konsep Adversarial Attack pertama kali dikenal secara luas pada tahun 2013 ketika peneliti menemukan bahwa model jaringan saraf tiruan bisa ditipu oleh perubahan kecil dalam input data. Penelitian ini menunjukkan bahwa AI dapat sangat sensitif terhadap modifikasi kecil yang tidak terlihat oleh manusia.

Eksperimen awal dilakukan pada sistem pengenalan gambar, di mana gambar yang telah dimodifikasi sedikit bisa membuat sistem salah mengenali objek. Hal ini menunjukkan bahwa meskipun model memiliki akurasi tinggi, mereka tetap rentan terhadap serangan yang sistematis.

Dalam beberapa tahun terakhir, serangan ini telah diuji dalam berbagai domain, termasuk natural language processing, autonomous vehicles, dan bahkan sistem keamanan siber. Perkembangan ini memicu penelitian lanjutan untuk meningkatkan robustness dan keamanan model AI.

Cara Kerja Adversarial Attack

Adversarial Attack bekerja dengan menambahkan noise atau gangguan kecil pada input data, seperti gambar, teks, atau suara. Gangguan ini dirancang sedemikian rupa agar tidak terdeteksi oleh manusia, namun berdampak signifikan pada hasil prediksi model AI.

Biasanya, proses ini melibatkan gradient-based optimization, yaitu teknik yang mencari titik kelemahan model untuk menciptakan input yang menyesatkan. Serangan ini bisa dilakukan secara targeted, yaitu mengarahkan model untuk memberikan output tertentu, atau untargeted, cukup membuat model salah secara acak.

Pada praktiknya, Adversarial Attack memanfaatkan struktur matematis dari model deep learning seperti convolutional neural networks (CNN) dan recurrent neural networks (RNN). Serangan ini bisa dihasilkan melalui algoritma seperti FGSM (Fast Gradient Sign Method), BIM (Basic Iterative Method), dan PGD (Projected Gradient Descent).

Tujuan Adversarial Attack

Salah satu tujuan utama dari Adversarial Attack adalah untuk mengevaluasi seberapa tangguh dan resilient model AI dalam menghadapi gangguan. Ini penting dalam pengembangan sistem yang digunakan untuk tugas-tugas kritis seperti autonomous driving dan biometric authentication.

Selain itu, serangan ini juga digunakan oleh peneliti keamanan untuk mengidentifikasi kelemahan sistem sebelum dimanfaatkan oleh pihak jahat. Dalam konteks ini, Adversarial Attack menjadi bagian dari strategi ethical hacking atau penetration testing untuk AI.

Namun, di sisi negatifnya, tujuan dari serangan ini juga bisa bersifat destruktif. Pelaku jahat dapat menggunakan teknik ini untuk menipu sistem pengenalan wajah, sistem deteksi penipuan keuangan, atau bahkan sistem pertahanan siber yang berbasis AI.

Jenis-jenis Serangan Adversarial

Serangan adversarial adalah upaya untuk mengecoh sistem kecerdasan buatan (AI) dengan input yang telah dimodifikasi secara halus. Serangan ini dikategorikan berdasarkan berbagai pendekatan dan tujuan.

1. Berdasarkan Target Serangan

Targeted attack bertujuan membuat model salah prediksi ke kelas tertentu yang telah ditentukan. Misalnya, gambar panda diubah agar dikenali sebagai kucing secara spesifik.

Non-targeted attack hanya bertujuan agar prediksi model salah, tanpa mempedulikan kelas barunya. Ini lebih mudah dilakukan namun tetap berbahaya dalam skenario nyata.

2. Berdasarkan Tingkat Akses Penyerang

White-box attack dilakukan saat penyerang memiliki akses penuh terhadap model, parameter, dan arsitektur AI. Ini membuat serangan lebih presisi dan efektif.

Black-box attack terjadi saat penyerang tidak tahu isi model, hanya dapat mengamati input-output. Meski lebih sulit, metode ini makin berkembang melalui pendekatan transferabilitas.

3. Jenis Serangan Lanjutan

Poisoning attack menyisipkan data berbahaya ke proses pelatihan, merusak model sejak awal. Ini bisa disusupkan ke dataset publik atau proses labeling otomatis.

Evasion attack terjadi setelah model dilatih, saat input dimanipulasi untuk menghindari deteksi. Biasanya digunakan pada sistem deteksi ancaman atau sensor keamanan.

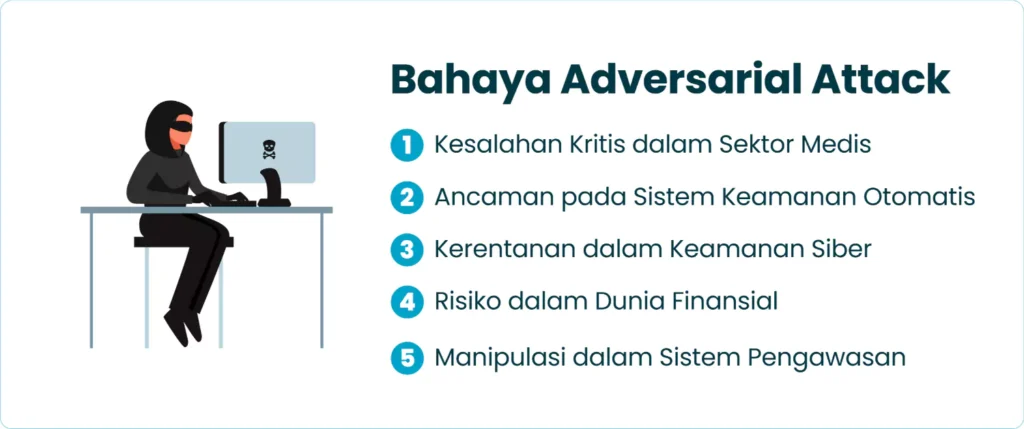

Bahaya Adversarial Attack

Serangan adversarial bukan sekadar eksperimen akademis—dampaknya nyata dan bisa membahayakan keselamatan, privasi, dan integritas data di berbagai sektor.

1. Kesalahan Kritis dalam Sektor Medis

Sistem AI dalam diagnosis medis bisa salah mengklasifikasi penyakit karena gangguan adversarial. Ini berisiko menyebabkan pengobatan yang salah atau tidak tepat waktu.

Dalam konteks radiologi, citra MRI atau X-ray yang disabotase bisa membuat tumor tak terdeteksi. Akibatnya, pasien tak mendapatkan penanganan yang diperlukan.

2. Ancaman pada Sistem Keamanan Otomatis

Mobil otonom sangat bergantung pada pengenalan citra dan sensor AI. Serangan bisa membuat mobil salah mengenali rambu lalu lintas atau pejalan kaki.

Ini bukan teori belaka; beberapa eksperimen menunjukkan bahwa stiker kecil bisa membuat AI mengira tanda stop adalah tanda kecepatan 45 km/jam.

3. Kerentanan dalam Keamanan Siber

Sistem deteksi malware atau intrusi bisa dilewati dengan file yang dimodifikasi secara halus. AI mungkin tak mengenali file berbahaya karena pola gangguan tersembunyi.

Hal ini memungkinkan malware menyusup tanpa terdeteksi, menjadikan adversarial attack sebagai alat baru dalam cyberwarfare dan peretasan sistem korporat.

4. Risiko dalam Dunia Finansial

AI digunakan dalam sistem perbankan untuk deteksi penipuan atau keputusan pinjaman. Serangan dapat membuat data tampak valid padahal mencurigakan.

Manipulasi seperti ini bisa merusak integritas lembaga keuangan, membahayakan nasabah, dan membuka celah besar dalam regulasi digital banking.

5. Manipulasi dalam Sistem Pengawasan

Kamera pengawas dengan sistem pengenalan wajah bisa dikelabui dengan kacamata atau pola wajah tertentu. Hal ini memungkinkan pelaku kejahatan menyusup.

Serangan ini sudah dibuktikan dalam studi akademik dan bisa menjadi ancaman serius di bandara, perbatasan, hingga sistem keamanan gedung pintar.

Jenis-Jenis Perturbasi dalam Adversarial Attack

Perturbasi adalah modifikasi kecil pada input yang tampak tak berbahaya bagi manusia, tetapi mampu mengecoh AI. Ada beberapa jenis pengukuran untuk ini.

1. L0 Norm (Jumlah Fitur yang Dimodifikasi)

L0 norm mengukur berapa banyak fitur input yang dimodifikasi, bukan besar perubahan. Cocok untuk serangan yang ingin minim deteksi visual.

Misalnya, hanya beberapa pixel dalam gambar yang diubah, namun cukup untuk membuat AI salah mengklasifikasikan objek secara signifikan.

2. L1 Norm (Jumlah Total Nilai Perturbasi)

L1 norm menghitung total nilai absolut dari semua perubahan pada fitur input. Ini memberi gambaran seberapa “jauh” input telah dimodifikasi secara keseluruhan.

Digunakan dalam skenario di mana total gangguan penting, meskipun tersebar di banyak fitur. Cocok untuk kontrol kualitas serangan.

3. L2 Norm (Jarak Euclidean)

L2 norm menghitung jarak Euclidean antara input asli dan yang telah terganggu. Semakin kecil jaraknya, semakin halus gangguannya.

Serangan L2 sangat umum karena menggabungkan jumlah dan kekuatan gangguan dengan cara yang seimbang dan realistis.

4. L∞ Norm (Nilai Maksimum Perturbasi)

L∞ norm mengukur gangguan maksimum pada satu fitur. Cocok untuk mengontrol seberapa “parah” satu titik bisa diubah tanpa deteksi. Serangan ini efektif untuk menguji batas toleransi sistem terhadap perubahan ekstrem pada satu bagian data.

Contoh Kasus Serangan Adversarial di Dunia Nyata

Beberapa serangan adversarial telah diuji di dunia nyata dan menunjukkan hasil yang mengejutkan. Ini membuktikan bahwa ancamannya bukan sekadar teori.

1. Figur Kura-Kura 3D

Sebuah model kura-kura 3D dicetak dan diuji terhadap sistem pengenalan objek. AI terus mengira itu senjata bahkan dari berbagai sudut pandang.

Kasus ini menunjukkan bahwa serangan bisa bersifat fisik, bukan hanya digital. Ini membuka peluang manipulasi di dunia nyata.

2. Gambar Anjing Menjadi Kucing

Dengan sedikit perubahan pixel, gambar anjing bisa dikenali AI sebagai kucing. Bagi manusia, gambar tetap terlihat sebagai anjing normal. Hal ini mengindikasikan betapa rentannya model visual terhadap perubahan kecil yang tidak kasat mata.

3. Sistem Pengenalan Wajah

Peneliti menggunakan aksesori seperti kacamata bercorak khusus untuk mengelabui sistem pengenalan wajah. AI gagal mengenali atau salah identifikasi. Serangan ini sangat berbahaya untuk sistem keamanan berbasis biometrik di bandara, kantor, atau perangkat pribadi.

4. Gangguan pada Asisten Virtual

Perintah suara tersembunyi (hidden voice commands) bisa ditanamkan dalam musik atau noise. Asisten virtual seperti Siri atau Alexa bisa disusupi.

Pengguna tidak menyadari bahwa AI menerima perintah berbahaya, misalnya membuka kunci pintu pintar atau mengirim informasi.

5. Kasus Chatbot Tay

Tay, chatbot buatan Microsoft, disusupi input berbahaya oleh pengguna Twitter. Dalam waktu singkat, Tay berubah menjadi chatbot dengan ujaran kebencian.

Ini menunjukkan bahwa AI yang belajar dari lingkungan terbuka sangat rentan terhadap adversarial input yang sistematis dan masif.

Serangan Adversarial, Ancaman Tersembunyi di Balik Kecanggihan AI

Serangan adversarial mungkin tampak seperti gangguan kecil pada data, namun dampaknya bisa sangat besar. Mulai dari kesalahan medis yang mengancam nyawa, hingga pelanggaran keamanan sistem otomatis, serangan ini mampu menggoyang fondasi kepercayaan terhadap teknologi AI.

Jika tidak ditangani dengan serius, serangan ini bisa menjadi senjata baru dalam dunia siber modern. Pengembangan AI yang tahan terhadap serangan adversarial adalah langkah krusial untuk menjaga keamanan, keakuratan, dan integritas sistem berbasis kecerdasan buatan di masa depan.

FAQ (Frequently Asked Question)

Apa yang dimaksud dengan adversarial attack dalam konteks kecerdasan buatan?

Adversarial attack adalah serangan yang dilakukan dengan cara memanipulasi input data sehingga model AI atau machine learning memberikan prediksi atau keputusan yang salah. Serangan ini biasanya tidak terlihat jelas oleh manusia, tetapi dapat mengecoh sistem yang sangat canggih sekalipun.

Mengapa adversarial attack dianggap berbahaya bagi sistem berbasis AI?

Adversarial attack berbahaya karena dapat merusak keandalan sistem AI, misalnya dalam pengenalan wajah, kendaraan otonom, atau sistem keamanan. Jika dibiarkan, serangan ini bisa membuat pengguna salah mengambil keputusan karena sistem menampilkan hasil yang keliru.

Bagaimana cara kerja adversarial attack dalam menipu model AI?

Cara kerja adversarial attack adalah dengan menambahkan gangguan kecil atau noise pada data input, seperti gambar, teks, atau suara. Gangguan ini sangat sulit dikenali oleh manusia, namun cukup untuk membuat model AI salah memprediksi.

Apa contoh nyata dari adversarial attack pada dunia nyata?

Contoh nyata adversarial attack adalah ketika gambar tanda stop dimodifikasi dengan sedikit noise hingga sistem pengenalan kendaraan otonom membaca tanda tersebut sebagai tanda lain. Hal ini sangat berbahaya karena dapat menyebabkan kecelakaan di jalan.

Apakah semua jenis model machine learning rentan terhadap adversarial attack?

Sebagian besar model machine learning, terutama yang berbasis deep learning, sangat rentan terhadap adversarial attack. Hal ini karena model tersebut bekerja dengan pola numerik kompleks yang bisa dipengaruhi oleh gangguan kecil yang tidak kasat mata.

Apa perbedaan antara adversarial attack white-box dan black-box?

Dalam white-box attack, penyerang memiliki akses penuh terhadap arsitektur dan parameter model AI yang ditargetkan. Sedangkan dalam black-box attack, penyerang hanya bisa memanfaatkan input dan output tanpa mengetahui detail internal model.

Bagaimana adversarial attack digunakan dalam keamanan siber?

Dalam keamanan siber, adversarial attack bisa digunakan oleh peretas untuk mengelabui sistem deteksi intrusi atau filter spam. Dengan memodifikasi input data, penyerang bisa menyembunyikan aktivitas berbahaya agar tidak terdeteksi.

Apa langkah-langkah pencegahan yang bisa dilakukan untuk menghadapi adversarial attack?

Beberapa langkah pencegahan meliputi adversarial training, penggunaan model yang lebih robust, serta pengujian sistem dengan data yang sudah dimodifikasi. Dengan demikian, sistem bisa lebih siap menghadapi serangan yang bersifat manipulatif.

Apakah adversarial attack hanya terjadi pada gambar?

Tidak, adversarial attack tidak terbatas pada gambar saja. Serangan ini juga bisa terjadi pada teks, suara, bahkan data jaringan, sehingga hampir semua aplikasi AI berpotensi terkena dampaknya.

Mengapa penelitian tentang adversarial attack semakin penting di era modern ini?

Penelitian tentang adversarial attack semakin penting karena AI kini digunakan di berbagai bidang penting seperti kesehatan, keuangan, dan transportasi. Jika serangan ini tidak ditangani dengan baik, maka kepercayaan publik terhadap teknologi AI dapat menurun drastis.